Idea nagłaśniania instrumentów ma swoje początki jeszcze w XIX wieku, choć jakość ówczesnej, często eksperymentalnej aparatury pozostawiała wiele do życzenia. W okresie międzywojennym ta praktyka stała się o wiele powszechniejsza, także w związku z coraz śmielej pojawiającą się elektroniką. Już od lat 20. odbywały się koncerty z wykorzystaniem instrumentów elektronicznych, jak choćby Theremin, Trautonium czy fale Martenota. Często angażowały one także instrumenty akustyczne i już wówczas zauważono problem z uzyskaniem akustycznej spójności takiego materiału. Z jednej strony słuchacz miał do czynienia z dźwiękiem tradycyjnych instrumentów, z drugiej zaś z płynącym z głośnika tonem elektronicznym. Co przy ówczesnej jakości sprzętu nie ułatwiało sprawy. Ten problem przetrwał do przełomu lat 40. i 50. (właściwych narodzin muzyki elektroakustycznej), gdy zaczęły się pojawiać pierwsze utwory na instrument i taśmę, a potem formy live electronic. Wkrótce też doszło do znaczących zmian na scenie muzyki popularnej, które sprawiły, że nagłośnienie stało się czymś bardzo ważnym i wręcz niezbędnym.

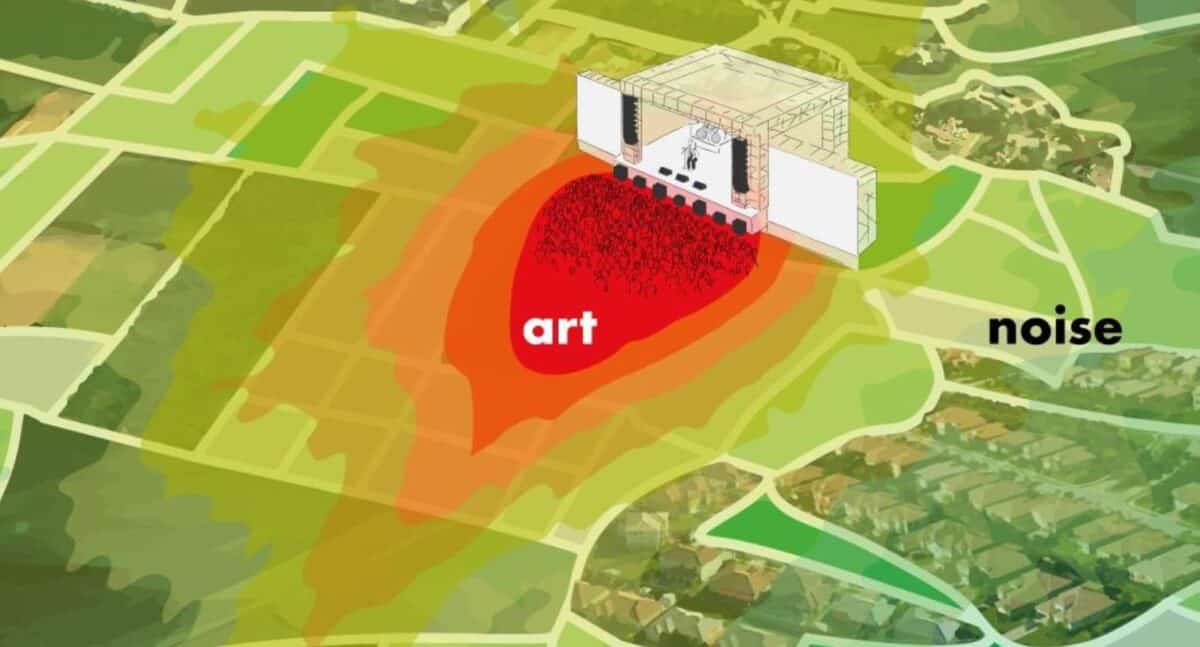

Ustawienie instrumentów na scenie wymaga uwzględnienia wielu czynników, w tym także wzajemnej widoczności i wygody.

Współcześnie możemy śmiało mówić o wszechobecności elektroniki, nasycona (często niestety wręcz przesycona) jest nią muzyka popularna, ma swoje miejsce w muzyce współczesnej, jazzie i innych gatunkach. Rozwój technologii sprawił, że połączenie takich dźwięków z instrumentami akustycznymi daje dziś znakomite efekty, choć nadal wymaga odpowiedniego podejścia, doświadczenia i po prostu dobrego słuchu realizatora dźwięku (a także samego kompozytora i muzyków). W tym artykule skupię się zatem na specyfice realizacji koncertów angażujących instrumenty akustyczne oraz elektronikę. Jak sprawić, by brzmienie było spójne, klarowne i każdy element miał swoje miejsce? Postaram się przyjrzeć kluczowym aspektom, które mają wpływ na efekt końcowy. Z oczywistych względów nie będzie to pełne kompendium wiedzy, ale raczej przewodnik dla osób, które zajmują się tym zagadnieniem, przede wszystkim zaś samych kompozytorów i wykonawców. Bo nawet, jeśli mamy szczęście brać udział w koncercie obsługiwanym przez fachowców, warto znać podstawy tej sztuki, by wiedzieć jak najlepiej wrazić swoje potrzeby i oczekiwania. Proszę także pamiętać, że realizatorzy to często osoby w szczególny sposób związane z konkretnymi gatunkami muzycznymi, mające własny gust i podejście – nie zawsze zbieżne z tym, czego chce występujący artysta. Pewne zasady są uniwersalne, jak choćby dotyczące rozstawiania mikrofonów, podłączania sprzętu, ale niektóre dotyczą konkretnych estetyk muzycznych i wymagają znajomości różnych gatunków. By nikt nie poczuł się dotknięty – realizacja koncertu rockowego jednak dość istotnie różni się od prezentacji muzyki współczesnej czy audiowizualnego dzieła multimedialnego. Zupełnie inne wyzwania stoją przed realizatorem, gdy w grę wchodzi nagłośnienie stereofoniczne, inne zaś gdy mamy do czynienia z wielokanałowością. Pomijam już to, że dość powszechną praktyką w przypadku muzyki współczesnej jest samodzielna realizacja dźwięku przez kompozytora. Wówczas rola realizatora całości sprowadza się do ogólnego zarządzania sprzętem i nagłośnieniem, ale podczas koncertu za konsoletą zasiada kompozytor i z tego miejsca nadaje swemu dziełu ostateczną postać. W każdym wypadku dobrze jest, gdy on sam (także gdy jest jednocześnie wykonawcą) miał świadomość, na czym polega dobre nagłośnienie, co chce uzyskać i jak się to robi, co w danych warunkach jest wykonalne, a co nie i jak znaleźć kompromis.

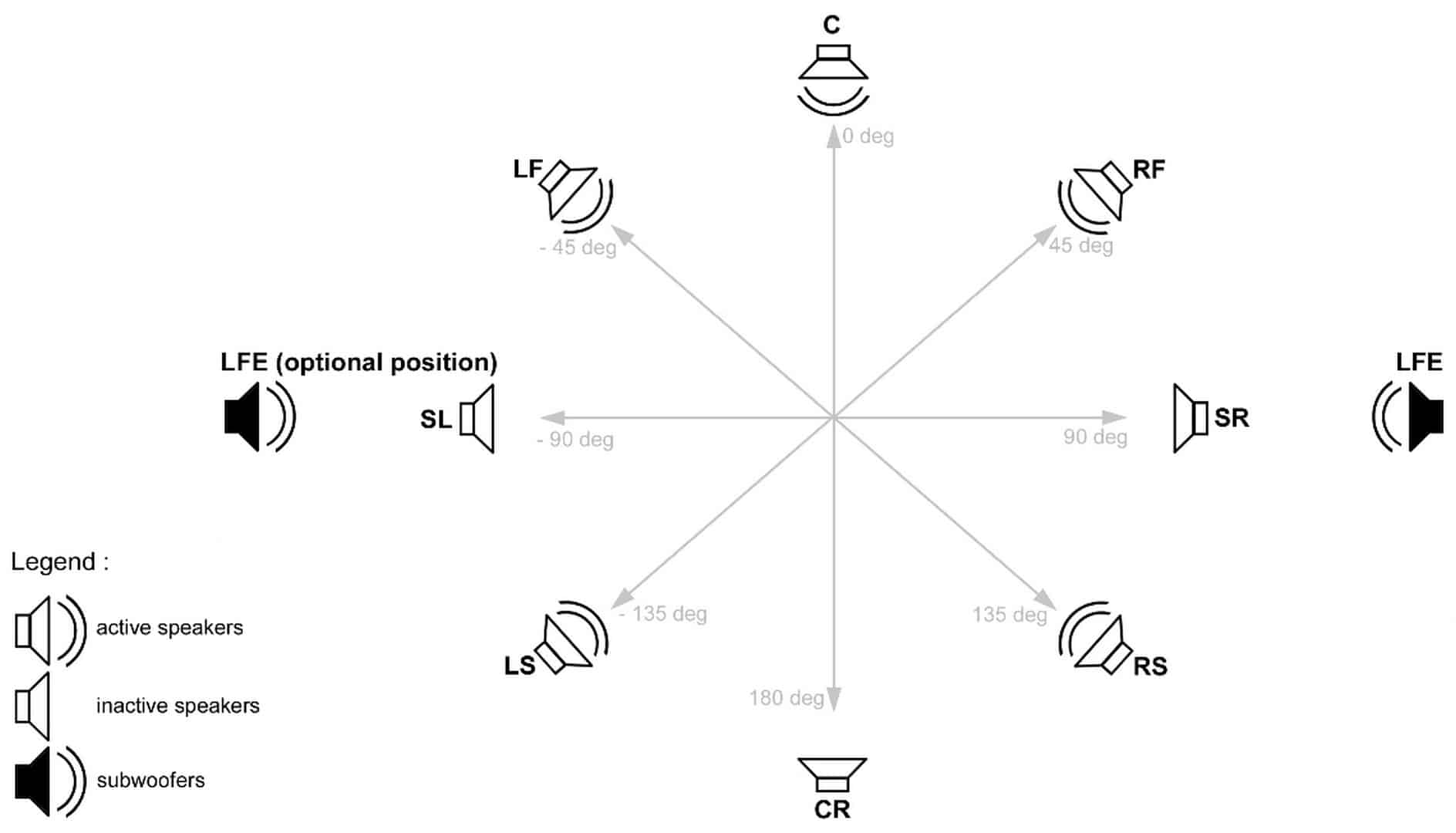

Pożądany układ głośników na sali może być częścią ridera technicznego.

Dlaczego nagłaśnia się instrumenty akustyczne?

Akustyczne instrumenty zwykle charakteryzują się pięknym, szlachetnym brzmieniem i słuchanie ich w czystej postaci to prawdziwa przyjemność. Kwartetu smyczkowego czy fortepianu w sali koncertowej nie trzeba nagłaśniać. Z zupełnie inną sytuacją zaczynamy mieć do czynienia gdy w repertuarze pojawia się elektronika – i to dotyczy każdego gatunku muzyki, czy to współczesnej, czy rockowej, czy piosenki aktorskiej, czy free jazu itd. Wymieńmy zatem, co jest celem nagłaśniania wspomnianych instrumentów:

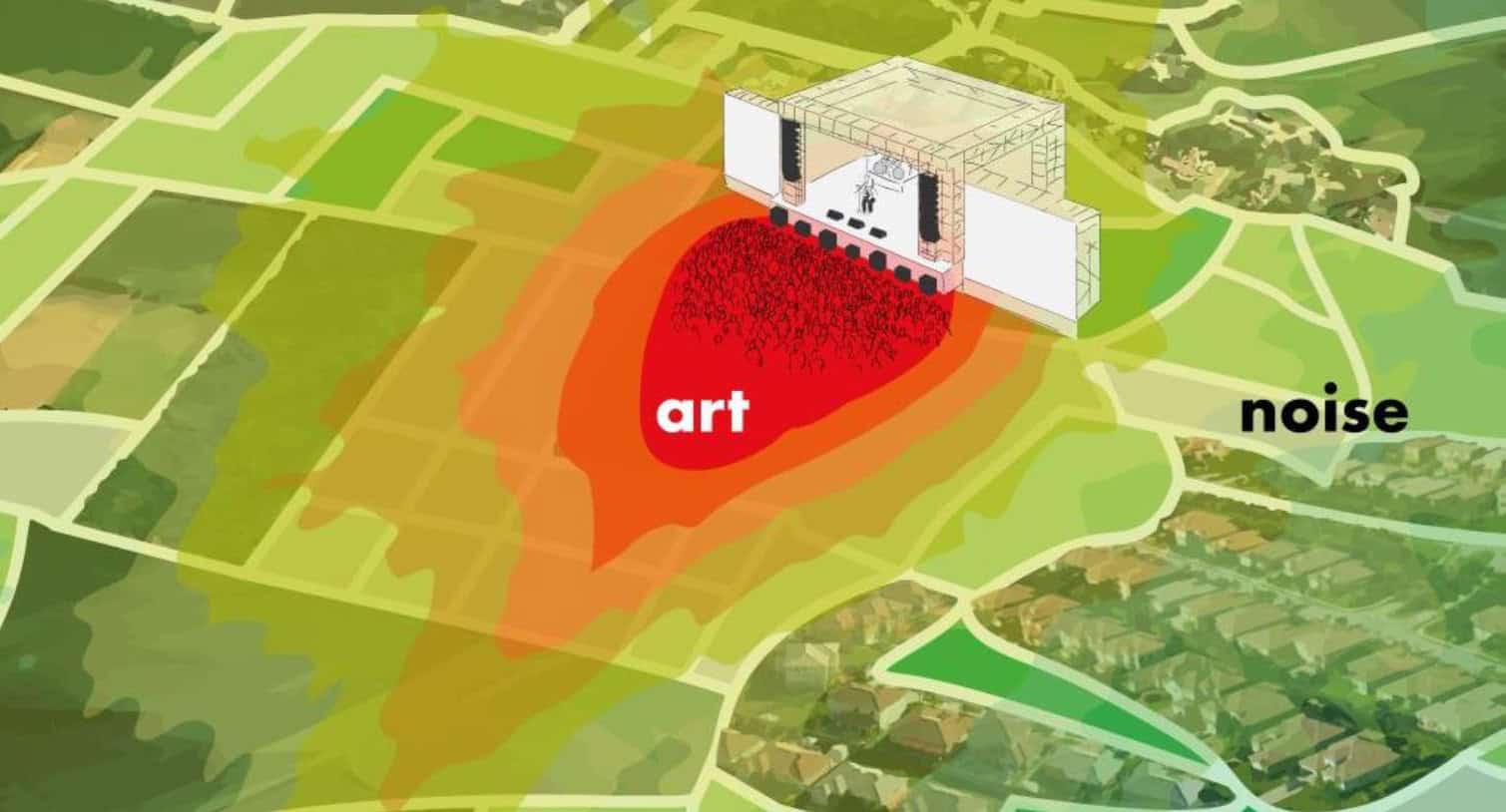

- po pierwsze, takie wzmocnienie dźwięku, by wypełnił przestrzeń, w której odbywa się koncert (a nie zawsze jest to typowa sala koncertowa), zarazem sprawiając, że muzykę usłyszy cała widownia i to bez względu na zajmowane miejsce,

- po drugie, wyrównanie poziomów różnych instrumentów, by całość zabrzmiała spójnie, a każdy plan dźwiękowy był jednakowo czytelny,

- po trzecie, ew. skompensowanie niekorzystnych cech charakterystyki akustycznej przestrzeni koncertowej, bowiem częstotliwości nie rozpowszechniają się równomiernie, inaczej rzecz ma się z niskimi, inaczej ze średnimi pasmami, czy też górą – zaś specyfika danego miejsca może dodatkowo zniekształcać naturalny obraz dźwiękowy poprzez podbicie, względnie tłumienie pewnych pasm,

- i wreszcie – co w przypadku koncertów z elektroniką jest szczególnie ważne – takiego połączenia obu składników, czysto akustycznego i elektronicznego, że powstanie spójna całość i słuchacz nie będzie mieć wrażenia, że obcuje z niepasującymi do siebie elementami.

Ostatni z wymienionych celów jest w kontekście omawianego zagadnienia szczególnie ważny – zdarzało mi się słyszeć opinie muzyków, że zwykle grali bez nagłaśniania, że ich instrument jest wystarczająco głośny itd. Tymczasem spróbujmy spojrzeć na to z perspektywy słuchacza – warstwa elektroniczna dociera do niego za pośrednictwem głośników, zaś akustyczny instrument słychać ze sceny, jego lokalizacja przestrzenna jest zupełnie inna, a percepcja samego dźwięku także różni się od partii nagłośnionych. Powstaje dysonans, który na pewno nie służy muzyce. Zdarzają się sytuacje, szczególne miejsca, gdy układ elektronika – akustyczny i w żaden sposób nie wzmacniany instrument się sprawdzi, ale w większość wypadków konieczne jest nagłośnienie wszystkiego, by efekt był spójny. Należy przy tym pamiętać o tym, że generalnie z punktu widzenia instrumentów akustycznych najlepiej jest gdy system audio jest transparentny, czyli nagłaśnia tak, jakby go nie było – innymi słowy, nie zmienia w żaden sposób percepcji odbiorcy, który słyszy czysty dźwięk akustyczny. Jeśli intencją twórcy utworu jest przekształcanie tegoż brzmienia, okraszanie efektami, to jest to kwestia obróbki elektronicznej, nie zaś samego nagłośnienia. Kolejną rzecz, którą trzeba mieć na uwadze – elektronika jest o wiele bardziej elastyczna, gdy chodzi o korekcję barwy, czy poziomu. Każdy instrument akustyczny charakteryzuje się pewną skalą dynamiczną i ten fakt musi uwzględnić kompozytor oraz realizator. Innymi słowy – elektronikę możemy ściszyć albo pogłośnić w zakresie od minimum do maksimum, instrumenty mają swoje ograniczenia. Dlatego już na etapie komponowania utworu warto mieć to na uwadze. Posłużę się tu przykładem – jeśli w określonym fragmencie muzyk ma zagrać forte i chcemy poziom instrumentu wyciągnąć tak, by zrównał się z elektroniką, to może się okazać, że w innym miejscu piano będzie za głośne w stosunku do warstwy elektronicznej. Można temu oczywiście zaradzić poprzez regulowanie poziomu na żywo, siedząc za konsoletą. Tym niemniej optymalnym rozwiązaniem jest takie, w którym ograniczamy manipulacje, zmniejszając ryzyko ew. błędów. Poza tym skale dynamiczne różnych instrumentów istotnie różnią się między sobą – np. zupełnie inną charakteryzuje się fortepian, inną zaś klawesyn. To także trzeba mieć na uwadze.

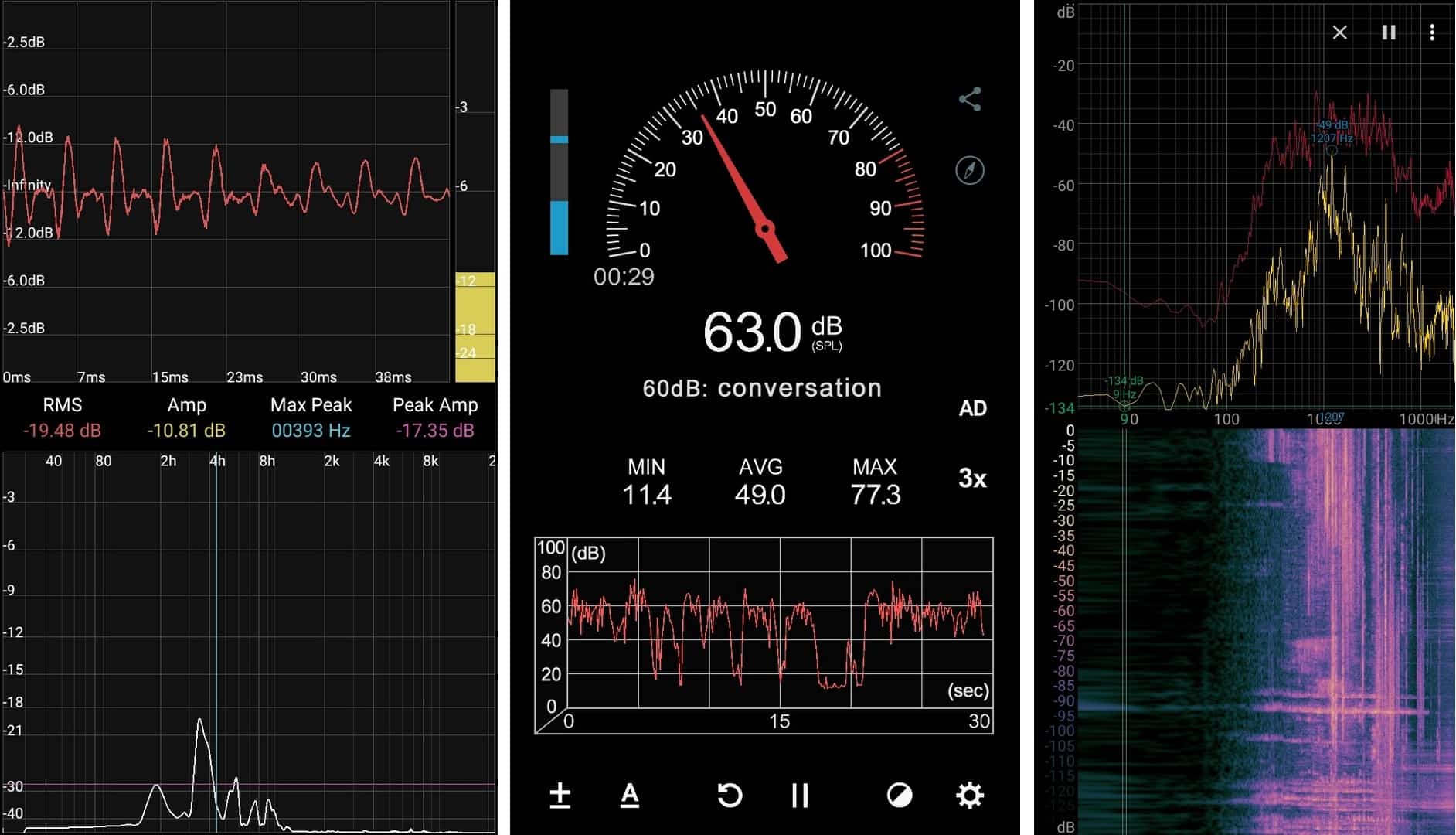

Przykłady prostych narzędzi akustycznych dla smartfonów

Nagłaśniając całość odpowiadamy na szereg pytań dotyczących finalnego efektu, w szczególności zaś:

- jak głośny ma być instrument dla publiczności,

- jaka ma być dystrybucja przestrzenna jego dźwięku (np. czy ma być bardziej słyszalny z przodu sali, mniej z tyłu, czy na odwrót, co zdarza się w przypadku realizacji wielokanałowych, czy też ma być ulokowany bardziej z lewej, względnie prawej strony),

- jakie mają być proporcje poszczególnych instrumentów, o ile w jednym utworze gra ich równocześnie więcej,

- jakie mają być proporcje żywych instrumentów w stosunku do warstwy elektronicznej,

- jakie są założenia estetyczne repertuaru koncertu,

- jaki jest styl gry danego muzyka (np. są pianiści mający tzw. ciężką rękę, jak i preferujący bardziej subtelną grę),

- jaka jest akustyka sali,

- jakie są oczekiwania i wizja samego kompozytora oraz wykonawców.

Musimy także pamiętać o tym, że publiczność będzie słyszeć nie tylko wzmocniony dźwięk z systemu audio, ale jednocześnie także sam instrument akustycznie ze sceny i powstanie swoisty miks tych dwóch składników. W różnych proporcjach, bowiem jedne instrumenty są głośniejsze od innych – na przykład wspomniany już parokrotnie fortepian jest bardzo wyraźny, mocny potrafi też być dźwięk akordeonu i wielu innych. Sztuką jest takie ustalenie proporcji, że uzyskany miks będzie brzmieć naturalnie, nie zakłóci odbioru muzyki (bardzo ważne jest także to, by w systemie audio nie pojawiła się psująca efekt latencja). Dlatego też dobrze jest najpierw ustawić dźwięk samego instrumentu, uzyskać właściwe proporcje i poziom, a następnie połączyć to z elektroniką – powtarzam, zawsze bardziej elastyczną i łatwiej poddającą się różnym zabiegom.

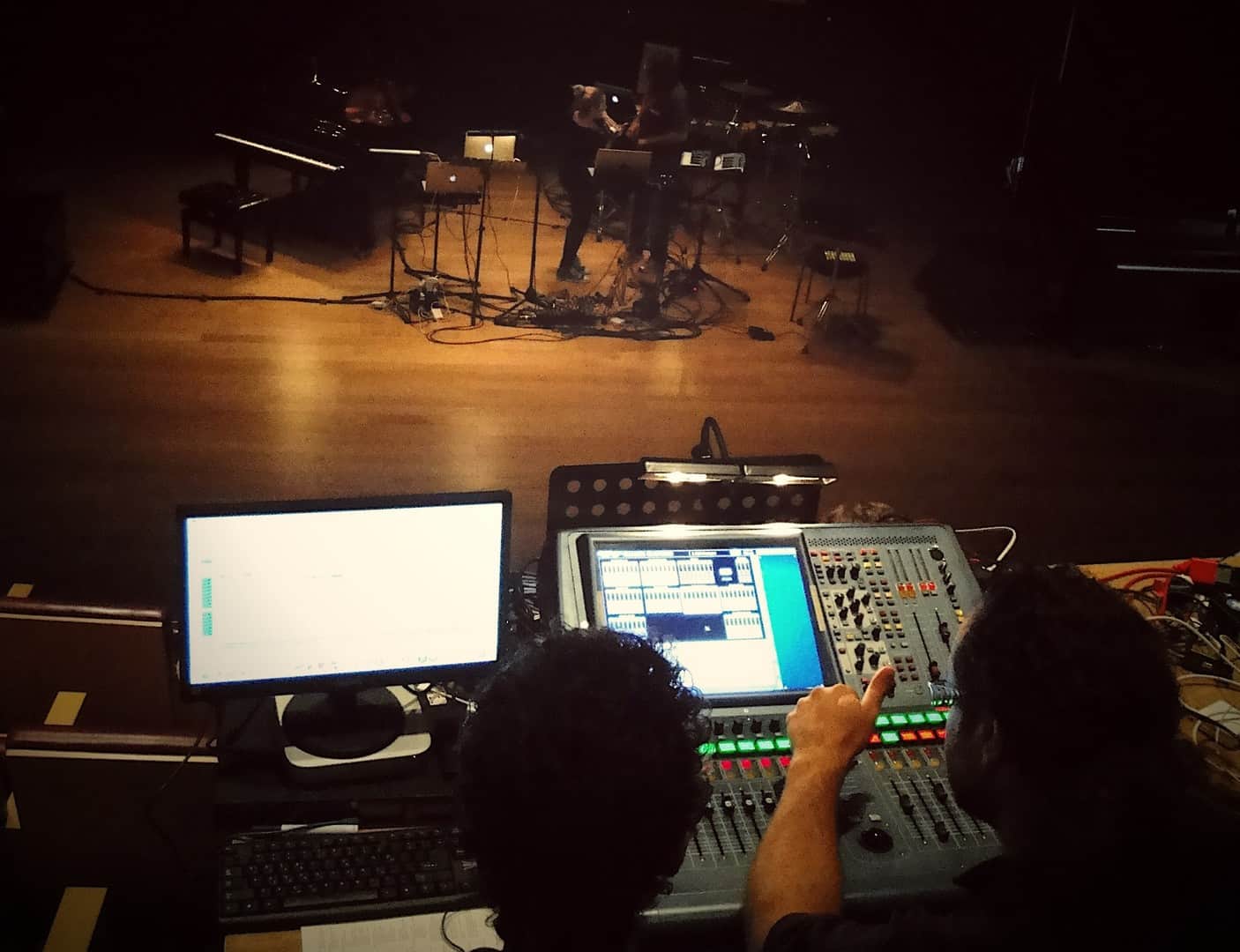

Często realizator musi mieć kontakt wzrokowy z wykonawcą, zwłaszcza gdy za konsoletą siedzi sam kompozytor.

Przygotowanie nagłośnienia koncertu

Na wstępie zaznaczę, że w ramach jednego artykułu nie sposób omówić szczegółowo metod omikrofonowania każdego instrumentu, tym bardziej, że nie ma jednej, uniwersalnej zasady – ustawienie, rodzaje i liczbę mikrofonów można różnicować, w zależności od oczekiwanego efektu, tego jaki charakter brzmienia chce się uzyskać – tutaj pole do popisu jest naprawdę duże. To temat na obszerną książkę, a i tak nie wyczerpałaby go w całości. Na szczęście dziś łatwo znaleźć różne tutoriale, poczytać, jak robią to inni – tą tematyką zajmujemy się i będziemy w przyszłości zajmować na łamach „Muzyki i Technologii”. Namawiam też jednak, by do wszelkich opracowań podchodzić z otwartą głową i pewną rezerwą. Większość pisana jest przez fachowców mających za sobą niezbędne doświadczenie, zresztą już po kilku zdaniach można poznać, czy autor wie, o czym pisze. Ale też z drugiej strony, jeśli napisano, że coś robi się właśnie w taki sposób, to nie znaczy, że żaden inny nie jest dopuszczalny. Zarówno muzyka, jak i realizacja dźwięku to dziedziny twórcze i zawsze warto poszukiwać, próbować – ale nie po omacku, lecz z pewną wiedzą i rozsądkiem. I nade wszystko kierować się własnym słuchem.

Wymieńmy zatem kilka kroków, które powinniśmy wykonać w trakcie przygotowania koncertu:

- zestawienie repertuaru, względne zapoznanie się z nim: jaką estetyką charakteryzują się utwory, jakie stwarzają wymagania techniczne, jaka będzie ich kolejność, jacy wykonawcy będą w nich grać, jakie są ich oczekiwania i potrzeby,

- spisanie realistycznego ridera technicznego, skonsultowanie go z wykonawcami i organizatorem koncertu – taki rider powinien zawierać wszystkie potrzeby sprzętowe, z uwzględnieniem ew. marginesu, by nie okazało się, że np. zabrakło jakiegoś kabla lub jest za krótki,

- ustalenie planu prób z czasowym harmonogramem udziału poszczególnych muzyków, w tym także planu ustawienia sprzętu przed samymi próbami, uwzględniając zapas czasu na ew. nieprzewidziane okoliczności,

- zapoznanie się (o ile jesteśmy w danym miejscu po raz pierwszy) z akustyką sali, jej specyfiką, dostępnym na miejscu sprzętem, jego stanem technicznym,

- zaplanowanie ustawienia muzyków i instrumentów na scenie.

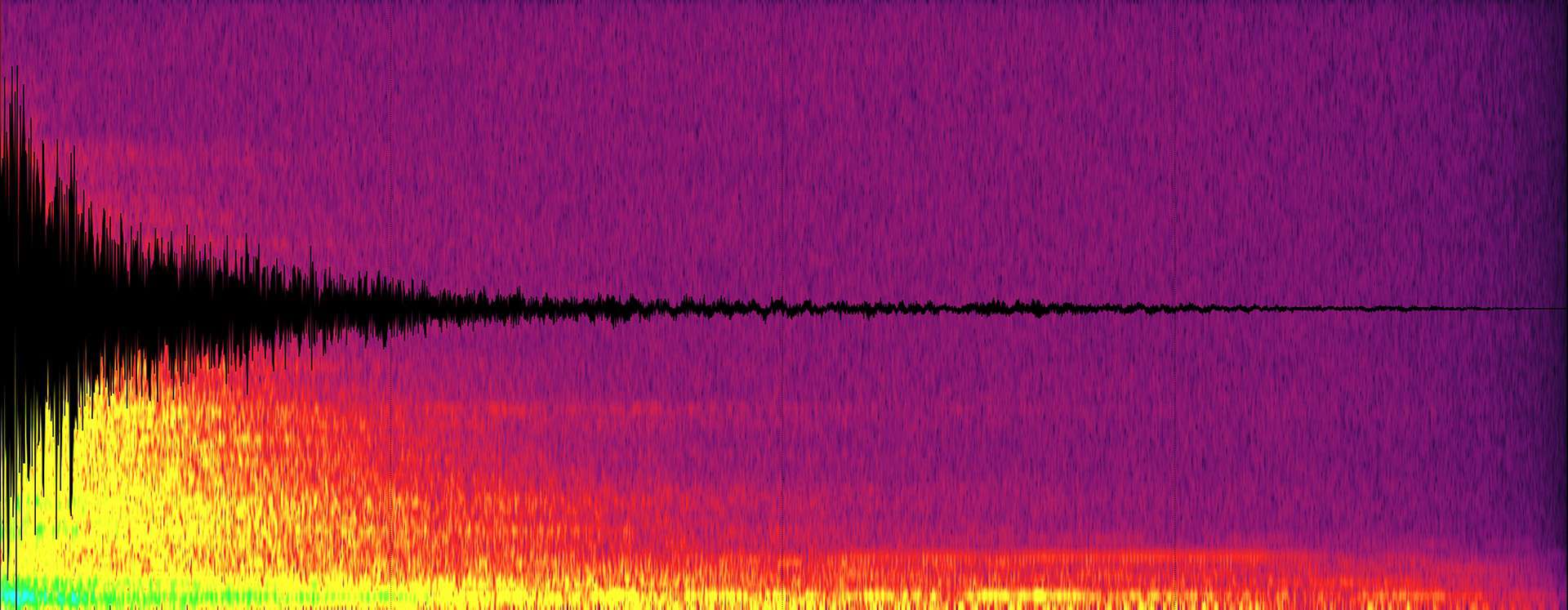

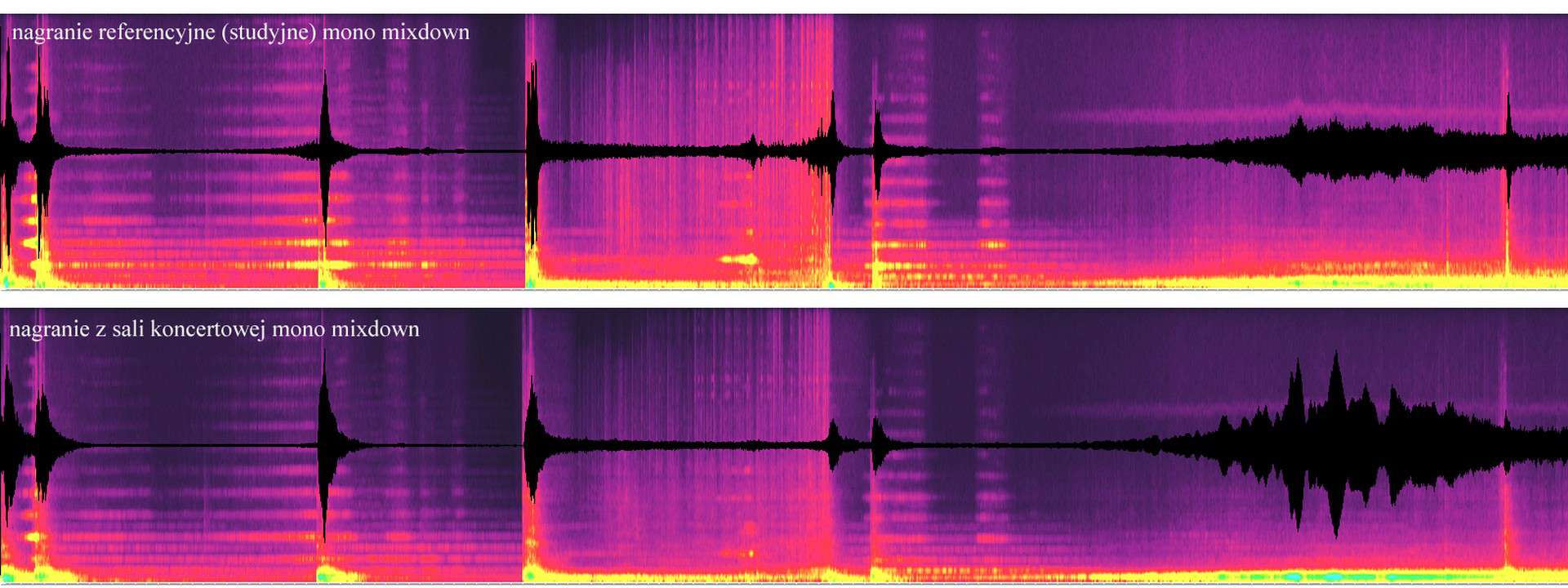

Analiza (spektralna i falowa) odpowiedzi impulsowej sali koncertowej

Znajomość akustyki pomieszczenia jest bardzo ważna, bowiem znacznie ułatwi nam pracę i pozwoli uniknąć niespodzianek. Weźmy pod uwagę, że jest ona składową, na którą nie mamy wpływu – po prostu bierzemy to, co jest i musimy się do lokalnych warunków dostosować. Nie zawsze przyjdzie nam grać koncert w miejscu, które powstało z myślą o muzyce, zatem owa akustyka też może być lepsza i gorsza. Bardziej pasująca do określonego typu muzyki itd. Zbadanie akustyki ułatwiają różne narzędzia – obecnie są nawet ciekawe aplikacje na smartfony, o być może ograniczonych możliwościach, ale niekiedy pomocne, zwłaszcza gdy skorzystamy z w miarę dobrego mikrofonu Bluetooth. Jednak zawsze ostateczny werdykt powinny wydać nasze uszy. Słowem – najważniejsze jest to, co realnie słychać, a niekoniecznie to, co pokazują różne analizatory. Na koncert przyjdą żywi słuchacze, a nie aparatura pomiarowa. Podpowiem rzecz, którą staram się stosować, jeśli tylko mam taką możliwość, mianowicie nagrywanie odpowiedzi impulsowej pomieszczenia, co daje jakieś wyobrażenie o akustyce, przenoszeniu różnych pasm i naturalnym pogłosie. Najlepiej jest wypuścić krótki „strzał” białego szumu (np. rzędu 100 ms) z głośników i nagrać mikrofonem odpowiedź sali. Uzyskaną próbkę możemy poddać analizie, a nawet załadować do pogłosu splotowego (convolution reverb), w celu sprawdzenia przed koncertami jak mniej więcej zabrzmią różne dźwięki w tym konkretnym miejscu. To oczywiście najlepiej sprawdza się, gdy regularnie gramy w tej sali i mamy czas na przygotowania.

Porównanie tego samego materiału audio w wersji studyjnej (na górze) i po odtworzeniu w sali koncertowej (na dole). Wyraźnie widać, jak akustyka pomieszczenia wpływa na odbiór muzyki.

Bardzo ważną kwestią jest odpowiednie zaplanowanie ustawienia wszystkiego na scenie. Jeśli będzie to występ solisty, duetu – problemu nie ma, nieco trudniej będzie pogodzić oczekiwania grupy wykonawców grających kolejno po sobie. Generalna zasada jest taka, by wszystko tak przygotować, aby potem już niczego podczas koncertu nie zmieniać, nie przestawiać statywów dla kolejnych wykonawców itd. Koncert powinien przebiegać płynnie i bez przestojów. Choć dla wielu czytelników to może zabrzmieć jak truizm, bardzo ważne jest także zabezpieczenie wszystkiego, zwłaszcza ciągnących się po podłodze kabli – by podczas koncertu, wychodzenia na scenę wykonawcy się o nie nie potykali. Występ to zawsze emocje, skupienie na muzyce, zatem łatwo o wpadkę. Ustawiając poszczególne instrumenty, statywy warto więc przewidzieć którędy muzyk ma dojść na miejsce i zapewnić, by po drodze nie zdarzyły mu się żadne przygody. To szczególnie ważne, gdy w koncercie bierze udział większa liczba wykonawców, którzy wchodzą kolejno po sobie. Warto pamiętać, że część z nich może nieść spore instrumenty (np. akordeon jest naprawdę ciężki i ogranicza pole widzenia), niektóre mogą mieć mikrofony na klipsach, a muzyk przed występem będzie się musiał podpiąć, więc nie może szukać kabla – powinien go mieć od razu pod ręką. To są drobiazgi, ale składające się na całość, jaką jest sprawnie przebiegający i udany koncert.

Jak zatem ustawić instrumenty na scenie? Pod uwagę bierzemy kilka kwestii:

- ustawienie ich w odległości umożliwiającej akustyczne odseparowanie, zatem takie omikrofonowanie, by sygnał sąsiednich instrumentów w możliwie najmniejszym stopniu przedostawał się do toru audio danego instrumentu (co generalnie jest trudne i nie zawsze w pełni możliwe),

- ulokowanie instrumentów o mocniejszym brzmieniu, głośniejszych, bardziej w głębi sceny (to może dotyczyć fortepianu, perkusji),

- uwzględnienie atrakcyjności wizualnej występu, wyeksponowania solistów i sprawienie, by publiczność widziała muzyków na scenie, gdy grają,

- ustawienie instrumentów możliwie daleko od monitorów nagłaśniających salę, by ich dźwięk nie przedostawał się za bardzo do mikrofonów,

- ustawienie w taki sposób, by muzycy grający w tym samym czasie mieli możliwość kontaktu wzrokowego, w niektórych wypadkach niezbędny jest także kontakt wzrokowy z realizatorem (zwłaszcza gdy jest nim sam kompozytor),

- w przypadku koncertów z projekcją wideo takie ustawienie, by muzycy nie zasłaniali ekranu (dobrze jest także umieścić go nieco wyżej), a jednocześnie, by nie oślepiało ich światło projektora.

Stanowisko realizatora z konsoletą może się znajdować np. tuż przed sceną albo pośrodku widowni.

Kwestią bardzo istotną jest lokalizacja stanowiska realizatora, z konsoletą i całym niezbędnym sprzętem. Wiele dużych sal koncertowych (np. filharmonie) ma osobne reżyserki, często w postaci zamkniętych pomieszczeń z własnymi odsłuchami. Trzeba jednak pamiętać, że ich rola jest zupełnie inna, sprawdzają się podczas rejestracji czy transmisji koncertu. Jeśli w grę wchodzi repertuar angażujący instrumenty akustyczne i elektronikę, realizator musi być na sali i reagować na to, co się na żywo dzieje. Naturalnym miejscem na konsoletę jest środek sali, zwłaszcza w przypadku realizacji wielokanałowych (w muzyce elektroakustycznej zdarza się to bardzo często, w innych gatunkach zdecydowanie rzadziej). Taka lokalizacja daje doskonały przegląd sytuacji i ocenę dźwięku trafiającego na salę, pozwala też na sprawne sterowanie ew. dyfuzją na żywo, panoramowaniem 3D itp. Są jednak pewne minusy – po pierwsze, zabiera się publiczności dobre miejsca, a to jednak dla niej grany jest koncert. Po drugie, wymusza wykorzystanie dłuższych kabli, o ile sala nie ma jakichś instalacji stałych. Nie ma tu złotego środka, wiele zależy od rodzaju muzyki, wielkości sali, jej akustyki, liczby używanych kanałów projekcji audio. Trzeba umieć ocenić sytuację i znaleźć kompromis. Sam często stosuję ustawienie konsolety na wysokości pierwszego rzędu siedzeń, przed sceną – ma to ten plus, że zapewnia także kontakt wzrokowy z muzykami, niezbędny w przypadku wielu utworów – np. gdy trzeba jednocześnie wystartować elektronikę, klik i partię akustyczną, dając muzykowi sygnał dłonią, względnie, gdy trzeba reagować na umówiony gest wykonawcy (np. by uruchomić jakąś próbkę czy pętlę).

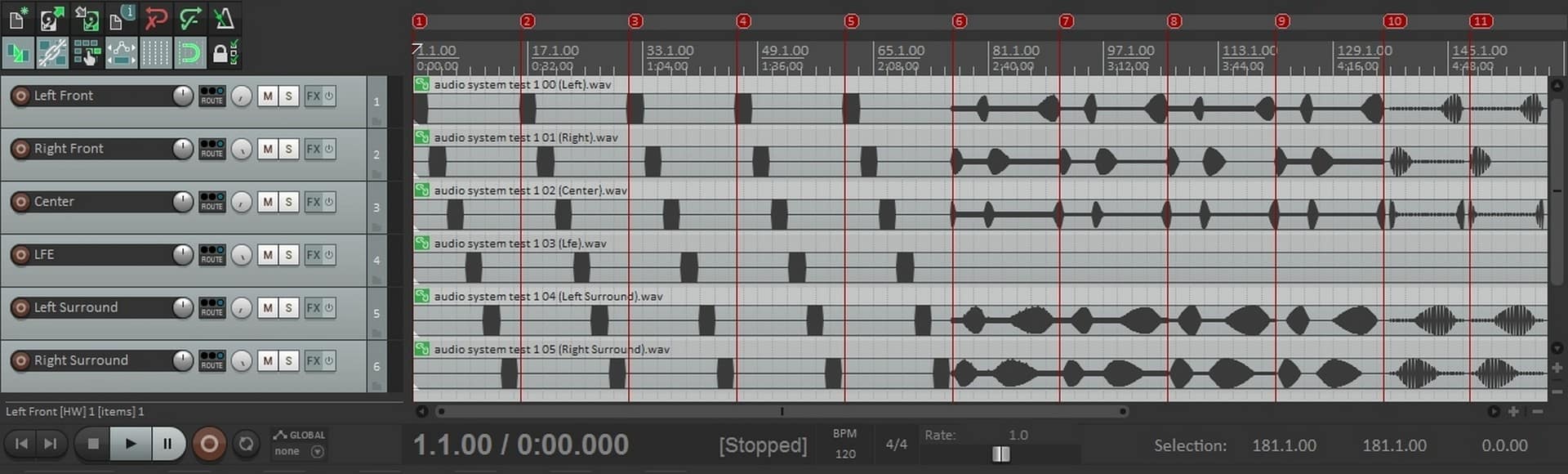

Przykład prostej sesji DAW do kalibracji nagłośnienia za pomocą szumów i sinusoid.

Kolejna rzecz, która jest oczywista dla każdego, kto ma na koncie choć parę koncertów – obecność publiczności na sali potrafi zauważalnie zmienić jej akustykę i to warto mieć na uwadze, ustawiając dźwięk na próbach. A publiczność to element nieprzewidywalny. Często nie wiemy, ile osób przyjdzie, jak usiądą, a to wszystko ma znaczenie. Tu potrzebne jest pewne doświadczenie i umiejętność wyobrażenia sobie, co może się zmienić i w jakim stopniu. Musimy zatem odpowiednio ustawić monitory, właściwie dobierając ich pozycję, kierunek czy też wysokość – w taki sposób, by zapewnić najlepszą dyfuzję dźwięku na całej sali. Dobrze jest wypróbować, jak to będzie brzmiało, nawet sprawdzić kilka wariantów. Kolejną bardzo istotną kwestią jest kalibracja nagłośnienia. Wykonujemy ją jeszcze przed przybyciem muzyków na próbę. Stosuję zwykle dość proste testy za pomocą szumów (białego i pasmowych), a także sinusoid (nie trzeba nawet mieć specjalnych narzędzi, stosowny projekt testowy można zrobić z oparciu o każdy DAW). Celem jest uzyskanie w miarę możliwości takiej samej charakterystyki z każdego monitora, a w dużym uproszczeniu, by każdy z nich dawał takie samo brzmienie, z takim samym poziomem itd. Ten proces jest absolutnie kluczowy z punktu widzenia końcowego efektu i bez niego nie uda się zrealizować dobrego koncertu. Sprawdzamy dźwięk nie tylko na środku, ale także w innych miejscach, pod kątem ew. problemów, właściwej dyfuzji, czytelności planów itp. Dobrze jest podczas próby obejść całą salę i posłuchać, jak to brzmi. Dodam, że często także nagrywam muzyków podczas prób i potem odtwarzam im fragmenty nagrania, by mieli jakieś wyobrażenie o tym, jak zabrzmią w czasie koncertu.

Choć czasy siermiężnych i cudem działających „gratów” na szczęście raczej minęły, zdarzają się miejsca, w których spotkamy mocno wyeksponowane nagłośnienie, lubiące sprawiać psikusy w rodzaju „na próbie brzmiało dobrze, na 10 minut przed sztuką coś się popsuło”. Posiadanie jakiegoś planu B, umiejętność radzenia sobie w trudnej sytuacji są zawsze mile widziane.

Tekst i zdjęcia: Dariusz Mazurowski, Muzyka i Technologia